DMR 入門

開始使用 Docker Model Runner。

啟用 Docker Model Runner

在 Docker Desktop 中啟用 DMR

- 在設定檢視中,轉到 AI 選項卡。

- 選擇 啟用 Docker Model Runner 設定。

- 如果您在 Windows 上使用受支援的 NVIDIA GPU,您還會看到並可以選擇 啟用 GPU 加速推理。

- 可選:要啟用 TCP 支援,請選擇 啟用主機端 TCP 支援。

- 在 埠 欄位中,輸入您要使用的埠。

- 如果您從本地前端 Web 應用程式與模型執行器互動,請在 CORS 允許來源 中,選擇模型執行器應接受請求的來源。來源是您的 Web 應用程式執行的 URL,例如

https://:3131。

您現在可以在 CLI 中使用 docker model 命令,並在 Docker Desktop 儀表板的 模型 選項卡中檢視和與本地模型互動。

重要提示對於 Docker Desktop 4.45 及更早版本,此設定位於 Beta 功能 選項卡下。

在 Docker Engine 中啟用 DMR

確保您已安裝 Docker Engine。

Docker Model Runner 可作為軟體包提供。要安裝它,請執行

$ sudo apt-get update $ sudo apt-get install docker-model-plugin$ sudo dnf update $ sudo dnf install docker-model-plugin測試安裝

$ docker model version $ docker model run ai/smollm2

注意Docker Engine 預設在埠

12434上啟用 TCP 支援。

在 Docker Engine 中更新 DMR

要在 Docker Engine 中更新 Docker Model Runner,請使用 docker model uninstall-runner 解除安裝它,然後重新安裝它。

docker model uninstall-runner --images && docker model install-runner注意使用上述命令,本地模型將被保留。要在升級期間刪除模型,請將

--models選項新增到uninstall-runner命令中。

拉取模型

模型在本地快取。

注意當您使用 Docker CLI 時,您還可以直接從 HuggingFace 拉取模型。

- 選擇 模型 並選擇 Docker Hub 選項卡。

- 找到您想要的模型並選擇 拉取。

使用 docker model pull 命令。例如

docker model pull ai/smollm2:360M-Q4_K_Mdocker model pull hf.co/bartowski/Llama-3.2-1B-Instruct-GGUF執行模型

- 選擇 模型 並選擇 本地 選項卡。

- 選擇播放按鈕。互動式聊天螢幕開啟。

配置模型

您可以使用 Docker Compose 配置模型,例如其最大令牌限制等。請參閱 模型和 Compose - 模型配置選項。

釋出模型

注意這適用於任何支援 OCI Artifacts 的容器登錄檔,而不僅僅是 Docker Hub。

您可以將現有模型標記為新名稱,並在不同的名稱空間和儲存庫下發布它們

# Tag a pulled model under a new name

$ docker model tag ai/smollm2 myorg/smollm2

# Push it to Docker Hub

$ docker model push myorg/smollm2有關更多詳細資訊,請參閱 docker model tag 和 docker model push 命令文件。

您還可以將 GGUF 格式的模型檔案打包為 OCI Artifact 並將其釋出到 Docker Hub。

# Download a model file in GGUF format, for example from HuggingFace

$ curl -L -o model.gguf https://huggingface.co/TheBloke/Mistral-7B-v0.1-GGUF/resolve/main/mistral-7b-v0.1.Q4_K_M.gguf

# Package it as OCI Artifact and push it to Docker Hub

$ docker model package --gguf "$(pwd)/model.gguf" --push myorg/mistral-7b-v0.1:Q4_K_M有關更多詳細資訊,請參閱 docker model package 命令文件。

故障排除

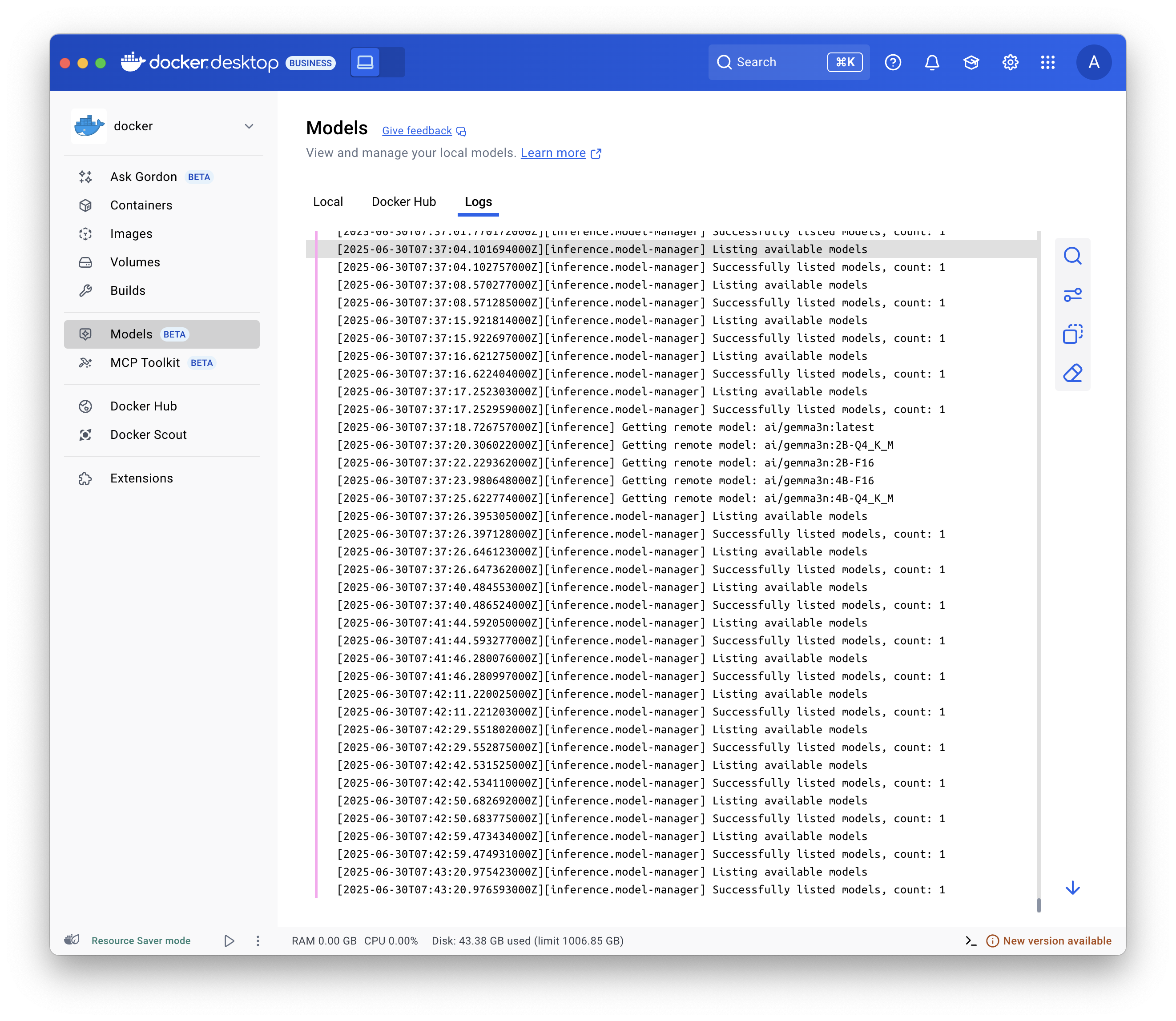

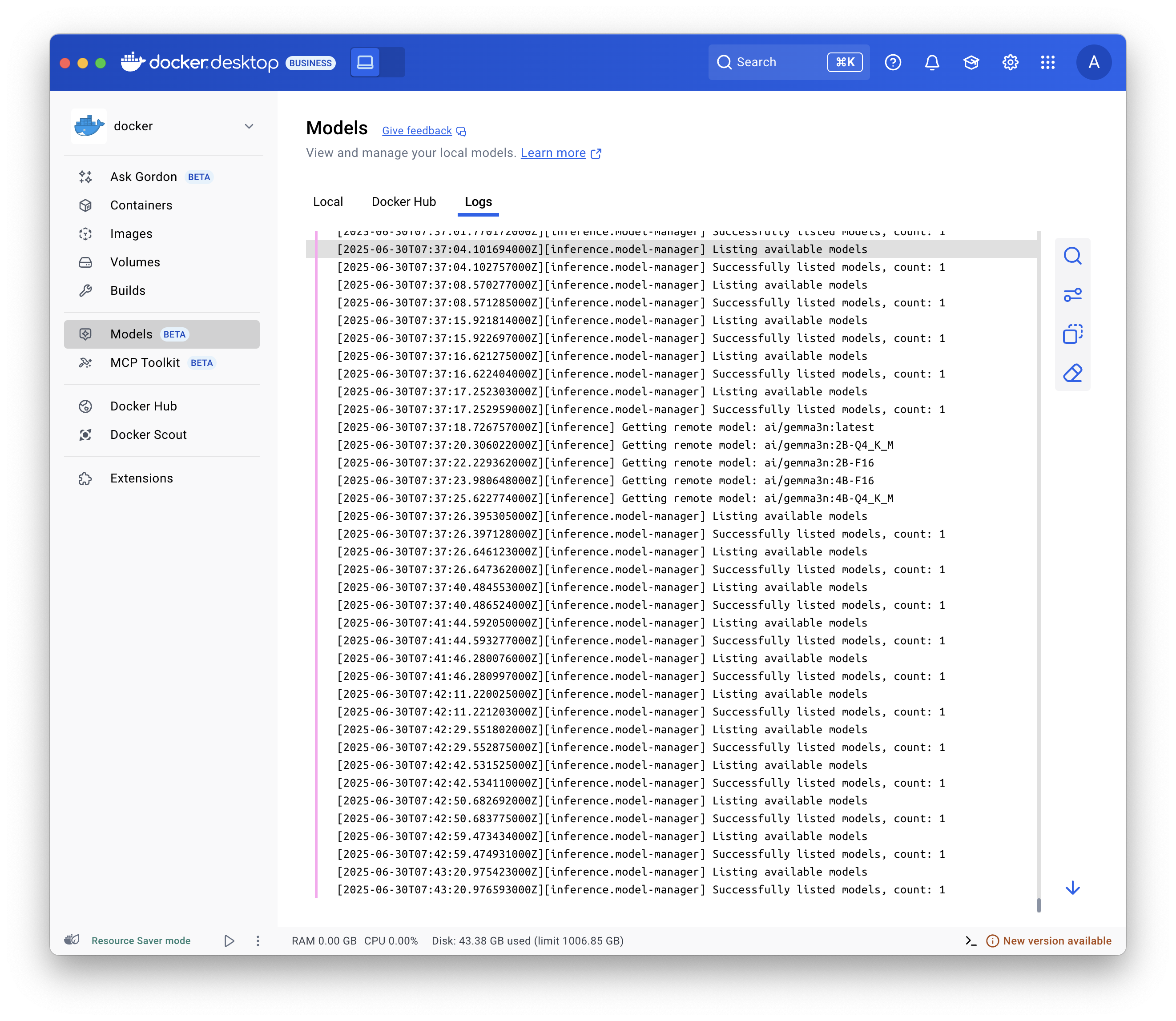

顯示日誌

要解決問題,請顯示日誌

選擇 模型 並選擇 日誌 選項卡。

檢查請求和響應

檢查請求和響應有助於診斷模型相關問題。例如,您可以評估上下文使用情況以驗證您是否保持在模型的上下文視窗內,或者顯示請求的完整正文以在使用框架進行開發時控制傳遞給模型的引數。

在 Docker Desktop 中,要檢查每個模型的請求和響應

- 選擇 模型 並選擇 請求 選項卡。此檢視顯示所有模型的所有請求

- 傳送請求的時間。

- 模型名稱和版本

- 提示/請求

- 上下文使用情況

- 生成響應所需的時間。

- 選擇其中一個請求以顯示更多詳細資訊

- 在 概述 選項卡中,檢視令牌使用情況、響應元資料和生成速度,以及實際的提示和響應。

- 在 請求 和 響應 選項卡中,檢視請求和響應的完整 JSON 有效負載。

注意您還可以在選擇模型後選擇 請求 選項卡時顯示特定模型的請求。